Qualche anno fa, scrivendo la tesi, ascoltavo spesso un brano strumentale che si chiama Cluster One, la traccia di apertura di The Division Bell dei Pink Floyd. La cosa mi divertiva perché il titolo richiamava esattamente quello che stavo facendo, ovvero clustering, un’analisi statistica su alcuni specifici database. Dovendo decidere come strutturare un articolo che parlasse anche di cluster, una delle prime cose che ho pensato è stata che avrei dovuto raccontare qualcosa sui Pink Floyd e su questo disco, quindi eccoci qua.

Nel 1994, quando i Pink Floyd pubblicano The Division Bell, i membri del gruppo non si sopportano più. Roger Waters se ne è andato da 10 anni, e i superstiti sono prostrati dalle dispute legali e da 30 anni di vita nello stardom musicale. Il disco, secondo le parole di David Gilmour, è un tentativo di mettere in musica i sentimenti relativi allo stato di incomunicabilità reciproca tra gli individui, che i membri della band stanno sperimentando sulla loro pelle.

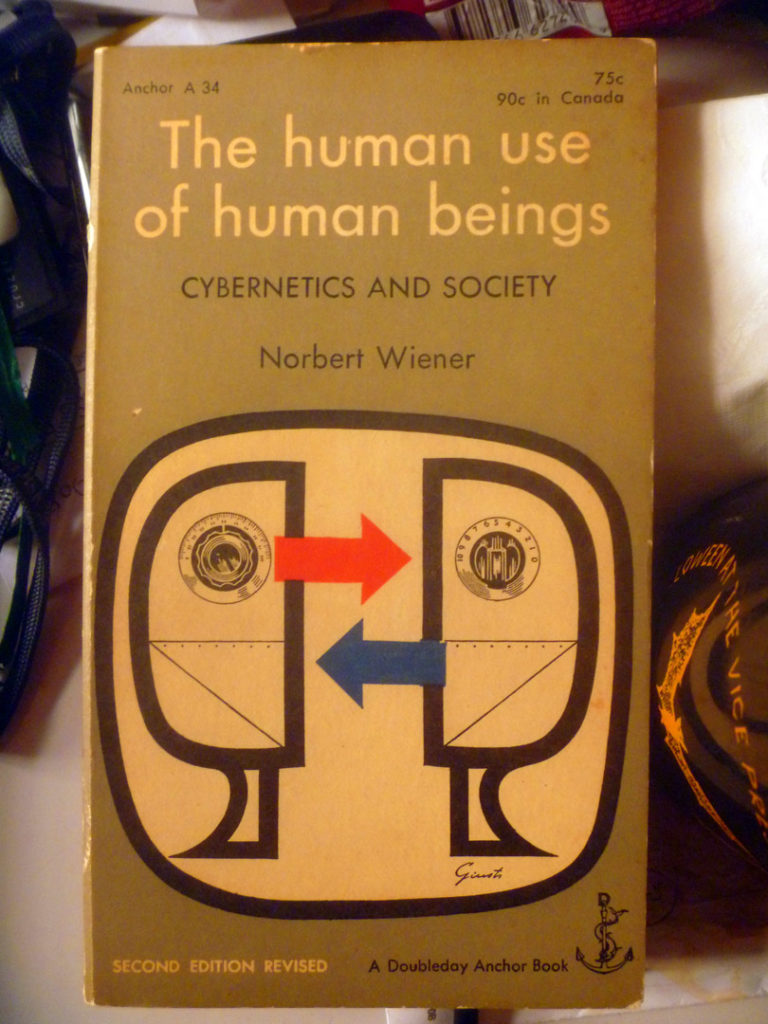

La celebre cover del disco, raffigurante le due teste giganti nell’atto di interagire tra loro, è un richiamo all’immagine di copertina di un libro del matematico Norbert Wiener, The Human Use of Human Beings. Al suo interno l’autore pose le basi della moderna cibernetica, concentrandosi sul rapporto tra uomo e automi. In un passaggio, in particolare, si pone l’accento sul pericolo che

“queste macchine, per quanto di per sé inermi, possono essere usate da un essere umano o da un blocco di esseri umani per aumentare il loro controllo sul resto della razza umana (…) non per mezzo delle macchine stesse, ma attraverso (…) tecniche talmente restrittive e indifferenti agli esseri umani da poter, di fatto, essere state concepite meccanicamente.”

Seppur figlio del clima di terrore atomico del secondo dopoguerra, il tema della cessione del proprio potere decisionale in maniera più o meno consapevole a meccanismi automatizzati non potrebbe essere più attuale al giorno d’oggi.

Dalla Treccani: La cibernetica integra nozioni e modelli neurofisiologici e biologicomolecolari con la teoria matematica dell’informazione, la teoria dei sistemi e la ricerca operativa, per progettare sistemi di controllo che comprendono processi di generazione, conservazione, trasmissione e utilizzo dell’informazione; tali sistemi sono incorporati sia nei servomeccanismi sia negli elaboratori elettronici.

Se il progresso tecnologico degli ultimi 25 anni ha nettamente semplificato le modalità comunicative, lo stesso non si può dire essersi avverato per il problema della comunicabilità a cui Gilmour si riferiva; il mondo dei social ha incoraggiato una serie di azioni autoriferite che vanno dal pubblicare foto della propria vita in vacanza fino a condividere le proprie canzoni preferite; gesti che a lungo andare hanno attivato un processo di confronto sul piano dell’ego piuttosto che una mediazione costruttiva; gesti che – tra le altre cose – hanno inondato la rete di informazioni che ci riguardano. È proprio a partire dalle informazioni che lasciamo inavvertitamente in giro per la rete che si alimentano i sistemi di Big Data, che rappresentano la materia prima tramite la quale sistemi automatizzati imparano a conoscerci e ad influire sulle nostre vite in maniera sempre più invasiva, concretizzando la profezia di Wiener.

Ne sentiamo parlare praticamente tutti i giorni ormai, ma cosa sono esattamente i Big Data? Immaginiamoli come insiemi di dati di enormi dimensioni (siamo nell’ordine dei terabyte), talmente complessi che per ricavarne un qualche utilizzo è stato necessario lo sviluppo di tecniche statistiche e algoritmiche avanzate che prendono il nome di data mining.

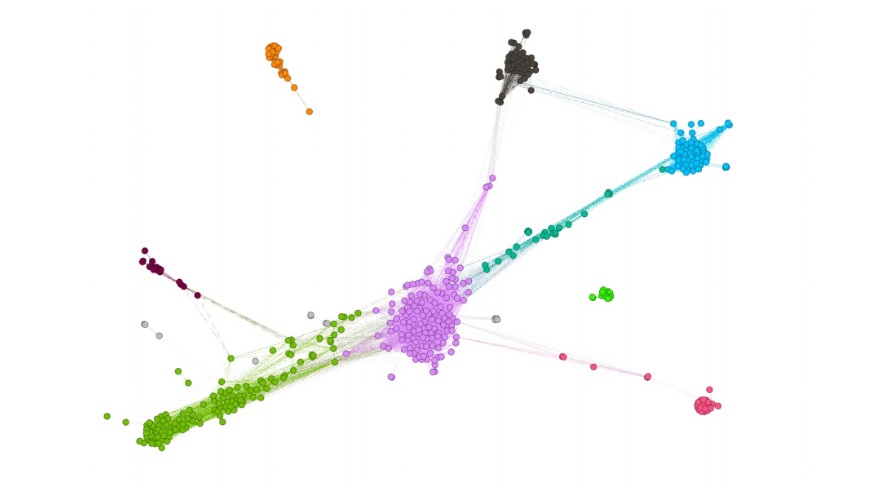

Il clustering che mi ha ricordato i Pink Floyd altro non è che uno dei più utilizzati metodi di data mining: semplificando all’estremo, tramite l’utilizzo di uno o più algoritmi si arriva a raggruppare elementi omogenei di un dataset all’interno di diversi insiemi, i cluster appunto. Ogni cluster sarà composto da elementi più simili tra loro di quanto non lo siano rispetto agli elementi che compongono gli altri gruppi del dataset. Frequentemente, gli elementi di ogni cluster sono a tutti gli effetti persone, utenti di servizi, siti, social network (gli stessi a cui abbiamo regalato per anni tutte le informazioni possibili su di noi); in questo caso gli insiemi descriveranno gruppi ben definiti di individui, e l’operazione prende il nome di profilazione. Lo scopo prettamente economico di una profilazione è evidente: per un’azienda la possibilità di ricavare informazioni dettagliate su ogni cluster di utenti può comportare in determinati frangenti l’acquisizione di un vantaggio competitivo rispetto ai propri concorrenti che sostanzialmente si traduce in valore.

Stanti tali premesse, appare logico che la letteratura di stampo manageriale abbia dedicato enorme rilevanza all’argomento, arrivando a formalizzare un sistema di parametrizzazione per i Big Data. Dobbiamo pertanto ringraziare un luminoso manager per aver trovato ancora una volta quattro parole con le stesse iniziali e aver coniato le cosiddette 4V:

Petabyte: indica una grandezza di 1 000 000 000 000 000 byte = 10005 = 1015 byte. Comunemente siamo abituati a pensare in termini di Giga = 109 byte.

V1 – Volume: indica la grandezza del dataset, che può arrivare a misurare anche diversi petabyte.

V2 – Variety: si riferisce alla omogeneità dei dati all’interno del set. Dati strutturati (per esempio una tabella Excel) saranno più facilmente processabili di dati non strutturati (commenti, file audio, video), per i quali sono necessarie tecniche di elaborazione più complesse, lunghe e costose.

V3 – Velocity: il tempo necessario a processare le informazioni è un parametro fondamentale; spesso si acquisisce un vantaggio competitivo da una veloce analisi del dataset, che diventa importante anche in caso fosse necessario trarre informazioni da dati ad alta deperibilità.

V4 – Veracity: quanto è accurato il data set che viene analizzato? La qualità e la pulizia dei dati raccolti sono basilari nei processi di business intelligence: dati “puliti” permettono di ottenere un data set ad alta significatività; al contrario, data set che contengono molto rumore avranno un’effettività ridotta. Esempi di set con alta veridicità sono quelli relativi ad esperimenti medici o scientifici, in cui ogni singola informazione viene estratta con le medesime regole precedentemente standardizzate.

Chi si è incaricato di formalizzare questi parametri ha deciso di esagerare: ecco quindi che, dall’analisi di un sistema di big data con queste caratteristiche, deriva la quinta V, il Valore attribuito alle informazioni estratte. Non esiste una regola aurea per determinare quali siano i dataset a maggior valore aggiunto: in linea di massima la capacità di analizzare con una alta velocità database formati da dati qualitativamente elevati dovrebbe comportare un ritorno in valore elevato. In un saggio presente all’interno di Datacrazia, Andrea Fumagalli fa notare come, in ogni caso,

il dato, in sé per sé, è caratterizzato da valore d’uso, come la forza lavoro […]. Esso si trasforma in valore di scambio all’interno di contesti in grado di utilizzare la tecnologia algoritmica appropriata.

Questo significa che saper analizzare i dati potrebbe essere fatica sprecata se non si sa esattamente come applicare i risultati di tali analisi. Diventa quindi fondamentale per le aziende investire in reparti di Business Intelligence che determinino quale direzione intraprendere una volta ottenute le informazioni necessarie. Informazioni che potrebbero essere estratte utilizzando i propri database, o acquistando dataset già cucinati da qualche data broker, aziende specializzate nel collezionare, ripulire e rivendere a terzi informazioni ricavate dall’attività di milioni di persone sul web.

Nella seconda parte di questa esplorazione vedremo come i data broker ricoprano un ruolo fondamentale nella elaborazione dei dati e nell’estrazione di valore da questi, nonostante nella maggior parte dei casi agiscano come una variabile fantasma all’interno del gioco.

Per approfondire:

- Andrea Fumagalli – Per una teoria del valore-rete: big data e processi di sussunzione. In D. Gambetta (a cura di), Datacrazia. Politica, cultura algoritmica e conflitti al tempo dei big data, DEditore, Ladispoli (Roma, 2019, pp. 46-69)

- Norbert Wiener – The Human Use of Human Beings. Boston, 1950. In italiano per Bollati Boringhieri